La puissance de l'Intelligence Artificielle est l'une des améliorations les plus visibles dans les algorithmes des moteurs de recherche depuis quelques années. Et des modèles comme GPT-3, d'Open AI, pourraient très prochainement modifier le paysage de la recherche d'informations et de la délivrance de contenus en ligne. Et par là-même, le visage du SEO. Explications...

La puissance de l'Intelligence Artificielle est l'une des améliorations les plus visibles dans les algorithmes des moteurs de recherche depuis quelques années. Et des modèles comme GPT-3, d'Open AI, pourraient très prochainement modifier le paysage de la recherche d'informations et de la délivrance de contenus en ligne. Et par là-même, le visage du SEO. Explications...

GPT-3 est le dernier modèle linguistique d'OpenAI. Il a fortement attiré l'attention l'année dernière, avec de nombreuses démos partagées sur les réseaux sociaux. À chaque fois, le principe est le même : vous donnez des consignes pour demander une génération de contenu plutôt que de cliquer ou programmer à travers un outil, et le rendu est toujours bluffant. Pour les projets SEO, cet outil est tout simplement génial par ses performances et sa prise en main. Mais les projets SEO ne sont qu'une partie de ce dont ce modèle est capable. Vous pouvez visiter ce site pour découvrir une tonne d’exemples : https://gpt3examples.com/.

Origine de GPT-3

Cette troisième version de ce modèle de Machine Learning, appelé donc GPT pour Generative Pre-trained Transformer, a vu le jour le 28 Mai 2020 lors de la publication du papier de recherche par les 31 ingénieurs de l’équipe d’OpenAI. Ce laboratoire de recherche en intelligence artificielle fondé à San Francisco par le bien-connu Elon Musk et Sam Altman n’en est pas à son coup d’essai.

D'ailleurs, Elon Musk a démissionné du conseil d’administration en 2018 mais reste un fervent donateur, et OpenAI a reçu en 2019 un investissement de 1 milliard de dollars. Ce budget colossal permet de travailler avec les meilleurs scientifiques de la planète mais surtout avec des moyens techniques très importants. L’objectif du laboratoire est de rendre ses découvertes accessibles, d’où son nom : OPEN + AI (pour Artificial Intelligence, bien sûr).

Les premiers modèles de génération de texte GPT-1 et GPT-2 ont été publiés directement en Open Source, mais GPT-2 (en 2019) était si performant que les chercheurs ont préféré donner en premier les modèles les moins performants, de peur que cela ne soit exploité à des fins nuisibles : spam, phishing, …

Au début de l’ouverture de GPT-3, les accès étaient donnés au compte-goutte, et il existe désormais une liste d’attente (le délai moyen est de 1 à 2 mois).

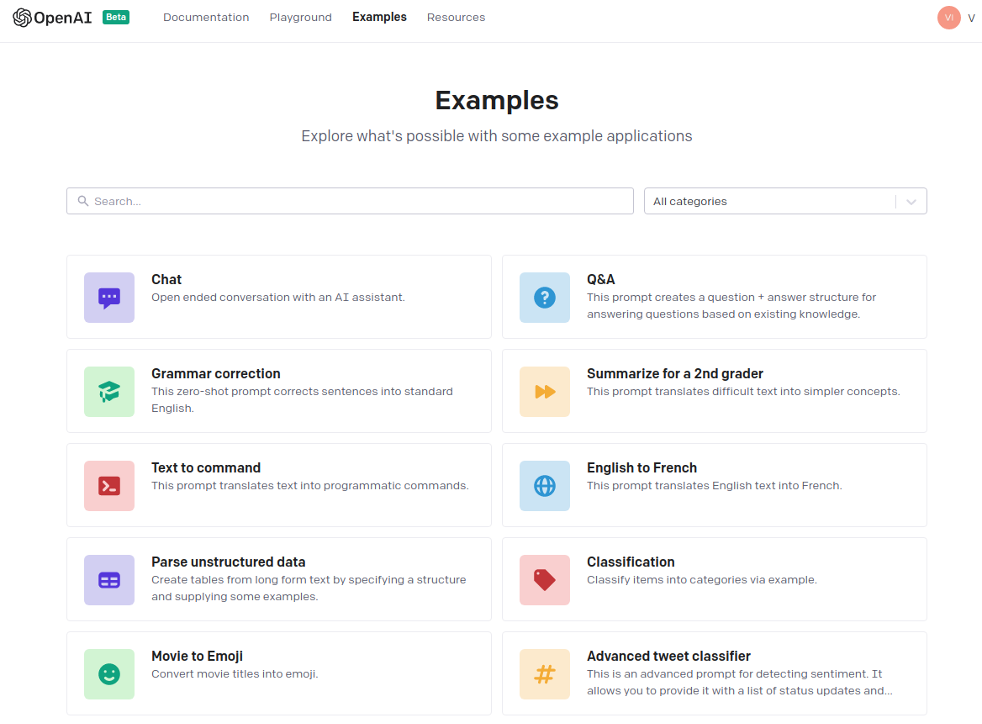

Comment le système fonctionne-t-il ? Une fois que vous êtes validé, vous allez pouvoir tester à travers une API et découvrir de nombreux use-cases prêts à l’emploi. Ils sont disponibles selon 5 catégories :

- Answers : moteur de réponses sur un thème précis ;

- Classification : classifier des intentions simples ou complexes ;

- Conversation : création de chatbot qui apprend de vos réponses ;

- Generation : générer des documents spécifiques (recettes de cuisine, etc.) ;

- Translation : traduction d’une langue, ou dans un autre langage de programmation.

Capture d'écran des démos présentes sur un compte OpenAI

GPT-3 marque les esprits non seulement par les types de tâche qu'il est capable de réaliser, mais aussi par la qualité de ses résultats. Depuis début 2021, tous les benchmarks confirment que GPT-3 obtient d'excellents résultats dans de nombreuses tâches NLP (Natural Language Processing ou traitement du langage naturel) comme la compréhension d’intentions complexes, ce qui le rend très utile dans le domaine du SEO. La particularité de ce modèle est qu’il est généraliste, c'est-à-dire qu’avec quelques exemples, il va comprendre ce qu’il doit produire comme résultat. On appelle ceci un modèle “few shot” en anglais.

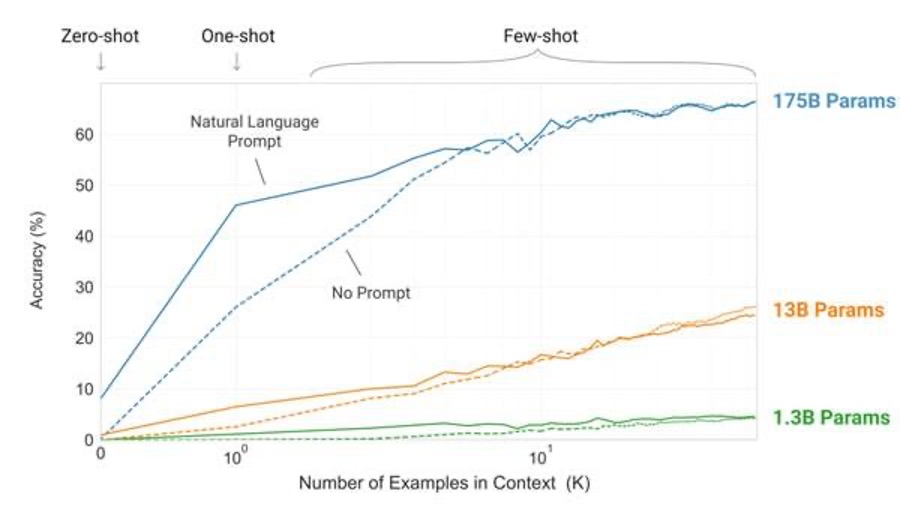

Voici ci-dessous un graphique représentant les performances en fonction du nombre d’exemples que vous lui donnez. Comme un humain, plus il reçoit d'instructions et d’exemples précis, mieux il réalisera la tâche que vous lui demandez. Ici l’efficacité passe de 10% à plus de 68% s’il a au moins 10 exemples.

Mesure des performances en fonction du nombre d'exemples fournis en entrée à GPT-3

Remarquez aussi sur ce graphique, que GPT-3 possède plus de 175 milliards de paramètres, en vulgarisation c’est le nombre de concepts qu’il est capable de comprendre. GPT-4 est déjà en cours avec 1 trillion de paramètres, donc là les performances deviendront hors normes.

Il faut savoir que plus le modèle va gérer de paramètres - ici on parle de 175 milliards - et meilleur il sera dans sa génération de texte car il maitrisera de plus en plus la compréhension du contexte et des intentions et donc les interactions seront bien meilleures.

Retenons aussi que ce joyau technologique est devenu très accessible grâce à plusieurs éléments.

Un mode ultra accessible de la génération de texte

GPT-3 est pour le moment proposé sous forme d’API avec une interface de test qui se nomme le playground. Vous serez complètement autonome sur le sujet avec une bonne formation d’environ 2 heures. GPT-3 ouvre donc la voie à un nouveau paradigme dans l'adoption de l'IA, et s’adresse en plus à des personnes non techniques pour les aider à intégrer les modèles GPT dans leurs produits et/ou leurs projets. Toute l’infrastructure, la maintenance et la détection de bugs sont gérés par les équipes de OpenAI. À l’heure où cet article est écrit, il existe une liste d’attente mais la commercialisation par Microsoft ne devrait plus tarder.

Une attention particulière a été portée sur la sécurité pour éviter des mauvais usages de cette génération de contenu. L’API est dotée d’un filtre qui vérifie chacune des requêtes générées, cela vous permet de ne pas afficher des générations de texte susceptibles de nuire, et en plus, de les signaler au support OpenAI.

Comment ça fonctionne ?

GPT-3 est un acronyme qui signifie "generative pre-trained”, soit “préformation générative” en français. Le mot "génératif" signifie qu’il peut générer de longues séquences de contenu. Le mot "préformation" signifie qu’il n'a pas été construit avec une connaissance de domaine précis mais de tous les domaines. Ce modèle est très fort par exemple pour calculer la probabilité d'apparition d’un mot en fonction des autres mots du texte.

Aucune magie pour réaliser cela, il se base sur deux grands concepts qui sont l’attention et l'apprentissage non supervisé.

Pour comprendre l’attention, il faut revenir un peu en arrière. En effet, des spécialistes de l’IA ont fait le constat que les modèles linguistiques analysaient toujours un même nombre de mots fixes pour déterminer le contexte. Cela donnait des résultats très insatisfaisant dans de nombreux domaines. Ils ont donc fait en sorte que le modèle linguistique puisse travailler avec des ensembles de mots de taille variable pour définir correctement le contexte, et ce concept s’appelle l’attention.

Ensuite, pour comprendre l’apprentissage non supervisé, nous allons expliquer dans un premier temps l’apprentissage supervisé. Par exemple, si la tâche à effectuer est une traduction, une phrase en français est fournie en entrée, et une traduction anglaise créée par un humain est fournie comme objectif souhaité. Le modèle apprend donc à faire les correspondances entre ce qu’on lui donne en entrée et en sortie.

Pour les modèles non supervisés comme GPT-3, fournir des données en entrée lui suffit pour générer tout ce qui lui manque et s’auto-entraîner.

Si nous allons dans le détail, GPT-3 fait partie de la grande famille des transformers comme BERT, c'est-à-dire un réseau de neurones avec de nombreuses couches pour encoder et décoder l’information. On parle de modèle auto-régressif car il fait des prédictions sur une partie à la fois, et se sert de sa prédiction en sortie pour décider de sa prochaine action : mettre en place une relation entre les mots, oublier le mot, faire une nouvelle prédiction, ...

Cette version de GPT-3 a été fortement améliorée par rapport à GPT-2 avec :

- une meilleure gestion de la mémoire ;

- une meilleure exécution des tâches en parallèle ;

- un ajout d’un nombre important de “decoders”, pour traduire les tokens qui passent dans le réseau de neurones en texte.

Ensuite, le réseau de neurones est toujours étudié selon 3 modes :

- Few-Shot : donner plusieurs exemples avec la description de la tâche, puis poser une description similaire et étudier la réponse du modèle ;

- One-Shot (1S) : identique au few-shot, mais on ne lui donne qu’un seul exemple ;

- Zero-Shot (0S) : identique au few-shot, mais aucun exemple est fourni.

Contrairement à un modèle de Machine Learning, les poids du réseau de neurones ne sont pas mis à jour, il en déduit et utilise les bons paramètres pour apporter la meilleure réponse possible.

Pour lui permettre d'apprendre, vous devinez qu’il faut donner énormément de données, pour qu’il puisse avoir tous les cas possibles.

Quelles données ont servi d'entraînement pour GPT-3 ?

Entre 2016 et 2019, GPT-3 a été entraîné sur toutes les pages crawlées par CommonCrawl, soit plus de 45 Go de données. CommonCrawl est une organisation à but non lucratif qui archive les pages les plus importantes du Web, le site principal est connu sous le nom de webarchive.org et il essaye de crawler chaque site qui les autorise au moins une fois par mois.

Les données de WebArchive n’ayant pas été satisfaisantes, l’équipe OpenAI a donc ajouté des contenus de livres (ils n’ont pas communiqué sur les sources exactes), l’ensemble du contenu de Wikipédia et tout ce qui lui manquait pour renforcer une approche holistique, soit une connaissance de tout !

D’un point de vue infrastructure, aucun chiffre n’a été communiqué mais on parle de plus de 5 millions de dollars pour la mise en place du modèle. En plus de cela, il faut ajouter toute l’infrastructure pour le maintenir et mettre à disposition les modèles.

Les IAs mises à disposition avec GPT-3

La team OpenAI propose différents moteurs selon la complexité de la tâche NLP à effectuer, et chaque moteur a un nom de scientifique connu.

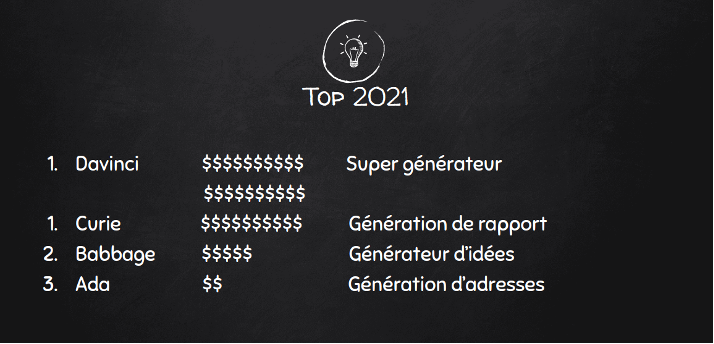

Voici ci-dessous un tableau qui recense les différents moteurs en fonction de leur coût. Les prix varient essentiellement en fonction du temps de réponse du moteur.

Comparatif des différents moteurs d'IA disponibles dans OpenAI

Pour résumer, le moteur Ada peut générer rapidement de grandes quantités de données, comme des noms et des adresses, à utiliser pour tester des applications et aussi extraire les principaux mots-clés d’un texte.

Ensuite, Babbage peut fonctionner comme un excellent outil de brainstorming et aider quelqu'un à compléter ses pensées. Si vous commencez un paragraphe ou une phrase, Babbage peut rapidement comprendre le contexte et servir d'assistant d'écriture.

Avec Curie, vous pouvez faire de la traduction et des classifications complexes. La force de ce moteur est de pouvoir extraire des informations pertinentes, comme par exemple les informations importantes d'un email.

Enfin, avec Davinci, vous pouvez détecter et extraire des intentions complexes, c'est-à-dire très ambigües.

Ce moteur est le meilleur en termes de génération de contenu en tenant compte de variantes, comme le style d'écriture et en paraphrasant au maximum.

Quelques contraintes à connaître

La première contrainte est qu’il n’est pas facile d’écrire les bonnes directives et de fournir les bons exemples pour ces premières générations, cela demande d’être formé et de lire de nombreux exemples.

La seconde contrainte à savoir est que les résumés de texte sont limités à 150 tokens.

Ensuite, GPT-3 étant entraîné sur des données datant de 2020 au maximum, vous ne pouvez pas générer du contenu sur des événements récents.

De plus, si vous créez un outil à destination de clients, les use-cases en SEO sont limités à 45 générations par heure et doivent répondre à des projets précis, comme la création d’une introduction, un résumé de texte, un ajout de CTA, et les optimisations de meta tags et de textes. Par contre, pour votre utilisation personnelle, vous ne serez limité que par votre quota: par défaut 200$, soit avec Davinci 33 333 générations, mais vous pouvez demander une augmentation de ce quota. Bien sûr, ces contraintes risquent d’évoluer dans le temps en fonction des découvertes et des avancées technologiques.

Si on revient sur le SEO, les risques majeurs restent l’utilisation de GPT-3 pour faire du Black Hat et ainsi manipuler les algorithmes de Google. Le système de quota empêche une personne mal intentionnée de créer des milliers de sites qui viendrait en plagier un autre en reformulant les articles. Des techniques de Text FingerPrinting ont été mises en place pour détecter les abus : plus vous avez d’articles générés de façon peu qualitative, et plus il sera facile pour Google de détecter que le contenu n’est pas écrit par un humain.

Depuis 2019 et l’arrivée de GPT-2, Google a mis à jour ses guidelines sur les contenus auto-générés. Les textes qui n’ont aucun sens, peu de sens, et/ou avec peu de valeur ajoutée pour le lecteur sont donc à éviter.

Google suit de près cette révolution et s’en sert à travers BERT pour devenir un moteur de réponse. Par exemple, si vous testez Google Analytics v4, vous pouvez directement lui poser des questions et il affiche les résultats.

GPT-3 est donc à utiliser avec modération pour créer des textes de qualité et utile pour vos utilisateurs, vous pouvez aussi tester des alternatives en attendant d’obtenir des accès.

Les alternatives

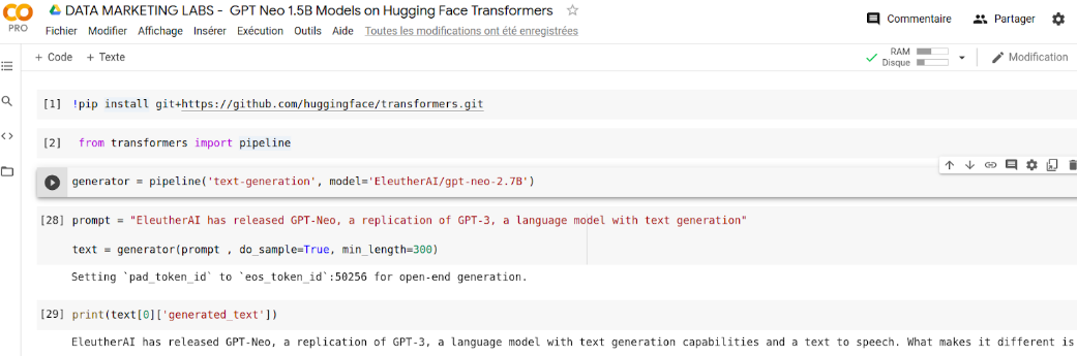

Il existe des alternatives open source, et si vous avez des connaissances en Data Science, nous vous invitons à tester GPT-Neo d’EleutherAI : https://github.com/EleutherAI/gpt-neo

Il faut savoir que les chercheurs d’EleutherAI sont partis des travaux sur GPT-2 puis ont entraîné leur réseau de neurones sur des infrastructures importantes, mais qui reste moindres que celles qui sont à la disposition de l’équipe de OpenAI. Ils ont créé deux modèles avec respectivement 1,3 milliards de paramètres et 2,7 milliards de paramètres.

De plus, avec la librairie Hugging face, il est très simple de tester Gpt-Neo, vous pouvez suivre la capture d’écran suivante pour les connaisseurs du langage Python :

Code Source en Python pour faire fonctionner GPT-Neo

Voici un comparatif condensé des performances entre GPT-3 et GPT-Neo basé sur les derniers benchmarks publiés en Avril 2021 :

- GPT-Neo surpasse GPT-3 Ada mais n’atteint le niveau des moteurs Davinci et Curie.

- Comme GPT-3 , il lui faut beaucoup d’exemples pour avoir de bons résultats.

- GPT-Neo est gratuit mais vous allez devoir gérer l'infrastructure, la maintenance et surtout le réentrainer pour vos usages spécifiques.

- GPT-3 est vraiment plus doué que GPT-Neo pour générer des textes dans une autre langue que l’anglais.

GPT-3 pour le SEO : un exemple concret avec OnCrawl

Lorsqu'on parle de la génération de texte, les utilisations pour le SEO sont nombreuses : création de fiches produits, production de lots de méta descriptions ou de titres… Lorsque les résultats sont de qualité, comme c'est le cas avec GPT-3, la génération de texte peut nous permettre de gagner du temps important, surtout avec un site de haute volumétrie.

Mais vous l'avez peut-être deviné, les utilisations pour le SEO vont largement au-delà de l'écriture automatisée du contenu. Des utilisations plus approfondies autour de la sémantique et l'intention de recherche sont également possibles.

Par exemple, l'outil Oncrawl teste depuis ce début d’année 2021 un générateur de maillage interne.

En effet, l’Inrank d’OnCrawl est une image du Page Rank: nous calculons pour chaque URL son PageRank par rapport à toutes les pages crawlées. Un client peut nous fournir un fichier plat comprenant la liste de ses pages à booster et celle de ses pages support. Avec l'aide de GPT-3, nous pouvons alors de recalculer un graphe de liens afin de respecter les relations sémantiques entre les pages, et d'injecter certains boosts sur les pages qui représentent des enjeux business. Les relations sémantiques permettent de ne mettre en place des liens qu’entre les pages qui ont des rapports entre elles. Si nous parlons de voyage au ski, l'outil ne proposera pas de liens vers les machines à laver. L’objectif est avant tout le visiteur et non les bots.

Afin d’être très pertinent sur la sémantique, nous utilisons le moteur Davinci de OpenAI afin d’extraire toutes les intentions de recherche les plus probables pour chacune des pages à booster. Nous avons noté des propositions correctes dans 90% des cas, mais afin de s’approcher des 99% de réussite, nous permettons à nos bêta-testeurs de suggérer les mots-clés à ne pas utiliser.

Les résultats de notre travail seront dévoilés dans les prochaines conférences OnCrawl en 2021.

Envie d’apprendre ?

Si vous souhaitez maîtriser et utiliser la génération de texte pour vos projets, des nouveaux cours au format digital existent depuis Avril 2021. Par ce travail, c’est plus de 4 ans de R&D qui sont partagés à travers 28 vidéos et 6 Google Colab. La première formation sur GPT-3 se trouve ici si vous souhaitez rester à la pointe de la génération de contenu : https://www.datamarketinglabs.com/guide-complet-sur-gpt-3

Et, pour votre information, cet article n’a pas été généré par GPT-3 mais le plan a été suggéré par GPT-3. 🙂

Le mot de la fin est bien ici d’insister qu’un abus de langage existe sur le mot “intelligence artificielle". Le mot juste serait certainement “intelligence augmentée”, car l’objectif n’est pas de se faire remplacer par quelque chose d’artificiel mais bien d’augmenter sa productivité en utilisant son intelligence. Et GPT-3 peut nous aider dans cette tâche...

Vincent Terrasi, formateur (Data Marketing Labs) et Directeur Produit OnCrawl (https://fr.oncrawl.com/)

La puissance de l'Intelligence Artificielle est l'une des améliorations les plus visibles dans les algorithmes des moteurs de recherche depuis quelques années. Et des modèles comme GPT-3, d'Open AI, pourraient très prochainement modifier le paysage de la recherche d'informations et de la délivrance de contenus en ligne. Et par là-même, le visage du SEO. Explications...

La puissance de l'Intelligence Artificielle est l'une des améliorations les plus visibles dans les algorithmes des moteurs de recherche depuis quelques années. Et des modèles comme GPT-3, d'Open AI, pourraient très prochainement modifier le paysage de la recherche d'informations et de la délivrance de contenus en ligne. Et par là-même, le visage du SEO. Explications...