Chaque mois, nous allons demander à une personnalité du SEO francophone sa vision du futur de notre métier à une échéance de 5 ans (au-delà on peut imaginer que c'est de la pure science-fiction). Ce mois-ci, c'est Philippe Yonnet, ancien président du SEO Camp et actuellement dirigeant-fondateur de l'agence Search Foresight, de nous donner sa vision de l'avenir de la visibilité sur les moteurs de recherche. Avec quelques secousses à prévoir pour certains si son approche se vérifie...

Par Philippe Yonnet

Par Philippe YonnetDepuis une dizaine d'années, les Cassandres de tous bords annoncent la fin proche du SEO. Et jusqu'ici, le référencement a continué d'afficher une santé insolente et reste une approche stratégique pour capter du trafic.

Mais aujourd'hui, j'estime que nous sommes au début de plusieurs ruptures technologiques qui risquent de changer définitivement le visage de ce que l'on appelle le SEO d'ici 5 ans, et dans des proportions si importantes qu'il faudra peut-être changer le nom de notre discipline.

Paradoxalement, si la mort du SEO « à l'ancienne » s'annonce, ce n'est probablement pas la fin des experts en référencement. En tout cas de certains, ceux qui vont pouvoir s'adapter au « changement climatique » qui s'annonce. Car quelques tempêtes de force 12 sont à prévoir pour les gens qui n'ont pas encore compris dans quelle direction le train fou du progrès technologique nous emmène…

A court terme, des référenceurs écartelés entre content marketing et SEO technique

Pour le moment, les anciennes techniques fonctionnent. Google conçoit son algorithme comme un mille feuilles, où les améliorations de l'algorithme s'empilent par couches, un peu comme les strates en géologie. Mais les « vieux » principes sont toujours à l'œuvre, ils constituent les fondations sur lesquelles sont construites les fonctionnalités les plus sophistiquées. Quand Google a présenté Rankbrain, l'une des premières briques de l'algorithme utilisant des technologies d'Intelligence Artificielle, tout le monde s'était étonné d'apprendre que cet élément avait été ajouté des mois auparavant sans que personne s'en aperçoive. En fait, Rankbrain a apporté une amélioration, pas une révolution.

C'est la situation aujourd'hui. Cela pourrait changer demain, beaucoup plus radicalement. En parallèle, les attentes des éditeurs de sites web vis-à-vis du SEO, et des experts, ont beaucoup évolué, et cela change peu à peu les contours du métier.

D'un côté, on demande aux experts en SEO de résoudre de plus en plus de challenges techniques, ce qui explique le renouveau du « technical SEO ». De l'autre, les clients comprennent que la visibilité dans les moteurs de recherche demande de plus en plus de disposer d'un contenu adapté, ce qui se traduit par la montée en puissance du content marketing.

La montée en puissance du SEO technique

La maîtrise des aspects techniques a toujours constitué l'un des fondements du référencement. Pourtant, le « Technical SEO » apparait en 2018 comme un nouveau buzzword.

Il est intéressant de constater qu'il a fallu attendre la période actuelle pour qu'une telle sous-discipline apparaisse. C'est le reflet d'une réalité : pour faire un site web aujourd'hui, il faut réunir des spécialistes (développeurs front, back, infras, designers web, etc.) là ou au début des années 2000 on pouvait s'adresser à un être hybride aux talents multiples : le webmaster. Jusqu'à une époque récente, les référenceurs devaient également maîtriser des compétences multiples.

Les référenceurs d'aujourd'hui ressemblent aux médecins généralistes, qui se décrivent souvent comme des spécialistes de médecine générale. Un SEO est un spécialiste d'une discipline transverse, qui l'amène à travailler avec tous les métiers du web, qui fonctionnent de plus en plus en silo.

Mais l'évolution rapide du Web a engendré l'apparition d'une race d'experts ultra spécialisée : les « SEO techniques ». En effet, de plus en plus de clients ont besoin d'être accompagnés sur des sujets que leurs équipes techniques maîtrisent peu ou mal, et qui ont des conséquences pour leur référencement.

On peut citer en particulier :

- Les technologies AJAX ;

- Les technologies mobile ;

- Les données structurées ;

- Le responsive web design ;

- Les framework Javascript (AngularJS, ReactJS, EmberJS…) ;

- Les nouveaux standards du web : https / http2, AMP, PWA… ;

- Et le challenge de l'amélioration des performances.

Fig.1. Le code javascript a envahi non seulement le contenu des pages web, mais sert aussi de plus en plus à les générer. Les challenges techniques que cela représente pour les moteurs de recherche demandent aux référenceurs d'acquérir des compétences pointues en développement pour prévenir les problèmes de crawl et d'indexation.

En parallèle, la démocratisation de l'accès aux crawlers et analyseurs de logs a créé une demande plus forte pour le référencement technique. Les éditeurs de sites web savent de plus en plus que traiter ce qui bloque ou gêne l'exploration ou l'indexation des pages web est un prérequis pour obtenir un bon référencement.

Comme la cadence des changements dans le domaine des technologies web est plutôt en train de s'accélérer au lieu de ralentir, le « technical SEO » est là pour durer. Je m'attends donc à voir le SEO technique monter encore en puissance et en visibilité au cours des prochaines années.

De « content is king » à « relevant content is king »

Une autre demande forte de nos clients en ce moment est d'être accompagné dans leur stratégie de création de contenus. Il y a dix ans, cela se traduisait par des demandes de production de contenus « optimisés pour le SEO », avec une approche souvent plus qualitative que quantitative.

Cette approche un peu « basique » fonctionne de moins en moins bien avec l'évolution des algorithmes des moteurs. Entre temps, le filtre Panda a fait son apparition. Et avoir un retour sur investissement correct pour un chantier de création de contenus demande d'élaborer des stratégies beaucoup plus fines qu'autrefois.

C'est là qu'intervient le « content marketing ». Le concept a fait son apparition aux USA il y a déjà 7 ou 8 ans. En France, c'est seulement depuis deux ou trois ans qu'il existe un vrai marché pour cette approche (l'évangélisation des clients demande du temps).

Le « content marketing » suppose de créer des contenus conçus spécialement pour la cible et pour les objectifs marketing d'un site web. On utilise souvent la méthode des personas pour identifier les typologies d'internautes-cibles et identifier les requêtes que ces internautes tapent durant une journée type. Les contenus à créer sont conçus pour être pertinents sur ces requêtes. Ensuite, on cherche à diffuser ces contenus pour qu'ils soient consultés par la cible via différents moyens de dissémination parmi lesquels les outils sociaux et le SEO ont un rôle clé à jouer.

Fig.2. Aux USA, les marketers pensent, selon les études compilées par l'agence enabler space,

que le content marketing a plus d'impact sur les ventes que le big data ou l'intelligence artificielle.

Les clients comprennent de mieux en mieux que « content is not king ». Le contenu n'est pas roi « per se », en tant que tel. Il faut un contenu adapté à ses objectifs et à sa cible, et un contenu pertinent pour être visibles sur les moteurs.

Cette discipline à part entière que constitue le content marketing demande pour la pratiquer des gens qui comprennent les stratégies de communication, les plateformes de marque, et les plans marketing des entreprises. Ils doivent aussi être capables de concevoir ou de challenger des guidelines éditoriaux, et de savoir gérer des workflow de production de contenus. Bref, on est loin du profil des SEO techniques.

On assiste donc bien à l'émergence de deux sous-spécialités au sein du SEO, exercées par des gens aux profils fondamementalement différents : les « content marketers » et les « technical SEOs ». C'est le résultat d'une poussée des extrêmes.

Le référencement local : une autre sous-discipline

J'aurai pu citer également comme spécialisation émergente le référencement local. C'est une réalité aux USA par exemple, c'est moins vrai en France où la concurrence sur les Google My Business, Maps et les pages de résultats locales est moins forte. Mais c'est effectivement une tendance lourde du marché, qui se poursuivra dans les prochaines années.

Moteurs de recherche : une rupture technologique en cours ?

Si le « look and feel” et les fonctionnalités des moteurs de recherche ont évolué avec le temps, rien de révolutionnaire ne s'est réellement passé depuis la création de Google en 1998. Mais nous sommes en train de connaître les prémices d'une rupture technologique qui peut complétement changer le concept-même de moteur de recherche, ce qui évidemment serait lourd de conséquences pour le SEO.

Faisons le point sur les innovations technologiques qui pourraient changer la donne au cours des années qui viennent...

Des entités nommées et des données structurées à tous les étages

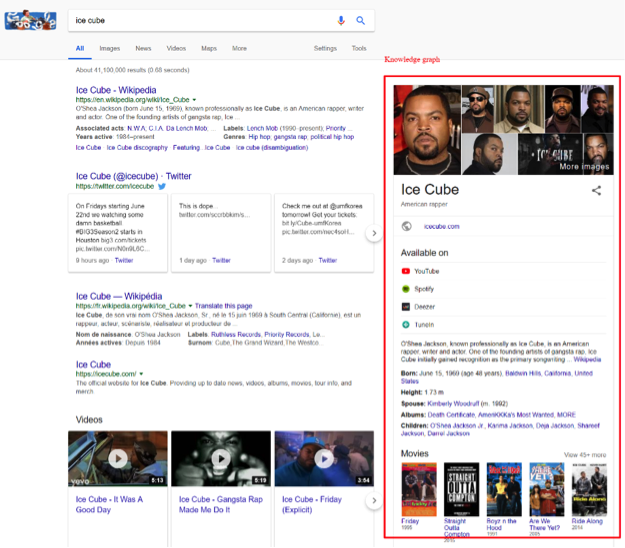

La REN ou Reconnaissances des Entités Nommées (les noms de personne, de lieu, de société, les dates etc.) est une technologie embarquée dans les moteurs de recherche depuis plusieurs années à présent. Les progrès en matière de REN sont constants. Ce qui progresse en parallèle est la capacité d'un moteur comme Google ou Bing à associer des faits à un nom de personne ou de lieu qu'il aura reconnu. Cela se manifeste notamment par l'affichage de blocs « Quick answers » ou « Knowledge Graph ». La base de faits du Knowledge Graph, limitée car essentiellement produite par des humains, fait peu à peu place à une base plus large collectée automatiquement sur vos sites : le « Knowledge Vault ».

Gageons qu'à l'avenir de plus en plus de requêtes afficheront des blocs Knowledge Graph. C'est autant de clics perdus pour les sites qui auront servi de source à cette collecte d'informations pour le graphe de connaissances de Google.

Fig.3. D'après la page de résultats de Google, ice cube n'est pas un glaçon ! La requête est reconnue comme associée à une entitée nommée, le nom d'un rappeur. Et Google fournit, grâce à sa base de faits et de relations, toute une série d'informations sur cette personne.

En parallèle, la systématisation de l'ajout de balises Schema.org pour permettre aux moteurs d'avoir accès à des données structurées est en train de transformer de manière spectaculaire l'apparence des pages de résultats, notamment en usage smartphone.

L'adoption progressive du balisage Schema.org devrait permettre aux moteurs de continuer à inventer de nouveaux formats intégrables dans les pages de résultats. Soulignons quand même que certains formats de type données structurées permettent là aussi à Google ou Bing de fournir directement une information à l'utilisateur sans qu'il ait besoin de cliquer sur votre page pour la voir. Dans certains cas (comme le prix d'un produit) cela n'a pas de conséquences réelles pour votre business (quoique ?), dans d'autres cas… ce sera plus gênant. Mais comment rester visible si, contrairement à vos concurrents, vous n'apparaissez pas dans les rich cards ou les rich snippets ?

Le balisage schema.org continuera à s'étendre dans les prochaines années selon moi. D'abord parce que la liste des balisages possibles s'étend sans arrêt. Et ensuite parce que l'adoption de ces balisages ne cesse de s'étendre également.

Le moteur de réponses

La REN et le Knowledge Graph ont déjà permis à Google d'évoluer vers un fonctionnement de type moteur de réponses. Un moteur traditionnel réagit à l'entrée d'une expression clé dans le champ de recherches par l'affichage de 10 liens bleus. Et c'est à vous de cliquer sur les liens qui vous semblent les plus pertinents pour trouver la réponse à la question implicite représentée par l'expression clé.

Un moteur de réponses cherche à donner directement la réponse à une question posée par un internaute. Il ne vous oblige pas à aller consulter plusieurs pages pour en extraire une réponse.

Ce concept a aujourd'hui une visibilité marginale dans une page de résultats (mais proéminente, la « réponse » figurant souvent en position zéro). Il est par contre central dans le fonctionnement des moteurs de recherche à partir de demain, avec la montée en puissance de la recherche vocale.

La recherche vocale

La recherche vocale, si elle devient un usage dominant (et cela en prend le chemin) peut créer une véritable rupture dans le fonctionnement des moteurs de recherche.

En effet, la recherche vocale pour bien fonctionner suppose une très bonne compréhension des questions posées en langage naturel. Depuis quelques années, les progrès faits dans le domaine de la fiabilité de reconnaissance du langage parlé, et du traitement automatisé du langage naturel ont ouvert la voie pour un usage généralisé des interfaces vocales.

Et cela suppose également de proposer une réponse « vocalisée ». L'obligation de vocaliser la réponse devient absolue quand le dispositif interrogé n'est plus un smartphone et ne dispose plus d'un écran, comme les hauts parleurs intelligents (Amazon Echo, Google Home), ou un objet connecté (montre Android, Thermostat Nest etc.).

Fig.4. Une conversation avec Google Home.

L'impact sur le référencement est ici très important :

- Les requêtes formées de mots clés tapés au clavier sont remplacées par des questions très variées vocalisées en langage naturel ;

- Et il n'y a plus qu'une seule réponse vocalisée, aux lieux de 10 liens proposés dans l'interface avec 10 liens bleus.

La fin du paradigme des mots clés

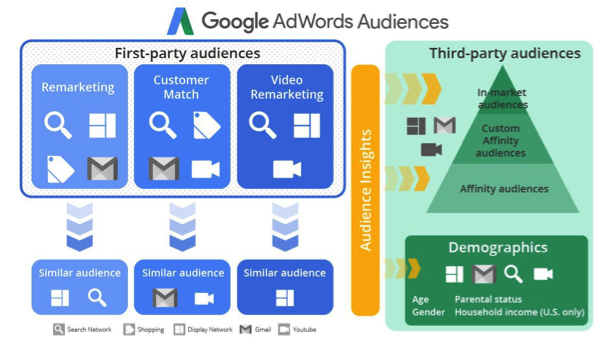

L'évolution des interfaces des moteurs de recherche condamne Google à changer subtilement son modèle. Le programme Adwords était basé sur annonces affichées en fonction de correspondance avec des requêtes, tapées sous forme de mots clés. Mais avec les interfaces vocales, les requêtes deviennent des questions formulées de manière extrêmement variées, et « matcher » avec chacune des variantes devient complexe, voire impossible.

Google a réagi en poussant de plus en plus des logiques de « correspondance d'audience ». Ce qui rapproche le fonctionnement du programme Adwords d'autres canaux (comme les outils sociaux).

Fig.5. Un aperçu des différentes possibilités de ciblage d'audience proposées par Google Adwords.

Mais c'est vrai aussi pour le SEO qui doit s'adapter à une nouvelle donne dans laquelle être bien positionné suppose comme prérequis d'être évalué par Google ou ses concurrents comme la meilleure réponse possible à une question des internautes. Dans quelques années, la montée en puissance de la recherche vocale suffira à rendre les stratégies d'optimisation « on page » sur les mots clés beaucoup moins efficaces qu'aujourd'hui.

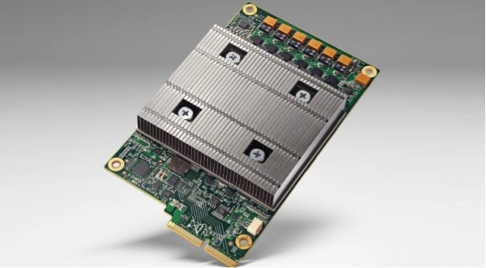

Google devient AI First

Par ailleurs, toute l'entreprise Google cherche à devenir AI First (et non « mobile First ») à marche forcée. Ce terme signifie que l'ensemble de la firme de Mountain View, son infrastructure, son organisation, ses process, ses produits, doit être pensée en s'appuyant sur les technologies d'Intelligence Artificielle. Sundar Pichai, le CEO de Google, a clairement annoncé cet objectif dès 2016. Cela a été répété en 2017.

En 2018, cela prend un tour concret. Tout d'abord, Google a tellement recentré sa recherche sur l'IA que son département de recherche s'appelle Google AI depuis mai. Ensuite, Google a créé toute une infrastructure de calcul (des « data centers ») entièrement conçus pour des applications d'IA utilisant des outils comme Tensor Flow. Enfin Google a développé des puces spéciales (les TPU) pour rendre plus efficaces les techniques de Deep Learning.

Fig.6. Une « TPU », les puces spécialisées pour les traitements utilisant Tensor Flow, développées par Google.

Les progrès dans ce domaine sont rapides, et la véritable rupture technologique dans les outils de recherche viendra selon moi en toute probabilité des progrès permis par l'Intelligence Artificielle.

La révolution sémantique et l'Intelligence Artificielle

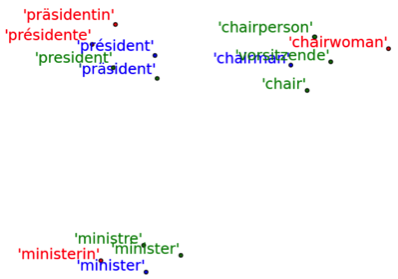

S'il y a un domaine dans lequel l'IA a déjà prouvé qu'elle permettait des progrès importants dans le fonctionnement des outils de recherche, c'est dans le traitement du Langage Naturel (NLP : Natural Language Processing). C'est grâce aux technologies d'apprentissage automatique et aux réseaux neuronaux que Google a pu faire des progrès décisifs sur la reconnaissance de la parole. Dans l'algorithme de classement, Google a expliqué que Rankbrain était le fruit de technologies de type IA et d'avancées en Traitement du Langage (le « plongement lexical »).

Nous sommes juste au début d'avancées importantes dans le domaine sémantique, permises par l'IA, et qui vont se glisser dans les outils de recherche et notre quotidien. On peut en attendre des progrès continus pour définir quelles pages constituent les meilleures réponses possibles aux requêtes des internautes. Et face à des moteurs toujours plus capables de détecter les pages les plus pertinentes (y compris dans une logique de personnalisation plus poussée), les anciennes méthodes pour attaquer l'algorithme de classement risquent de devenir de plus en plus inefficaces.

Fig.7. Le « plongement lexical » est une méthode capable, grâce à un réseau de neurones, de calculer les coordonnées d'un terme dans un espace virtuel sémantique. Cela permet de trouver les termes équivalents dans d'autres langues (les termes traduits se trouvent aux mêmes coordonnées sémantiques). Cette approche, basée sur l'IA, a permis à Google d'améliorer la couverture de Google Translate.

La recherche conversationnelle – les assistants

Ces progrès dans la compréhension du langage naturel et en Intelligence Artificielle permettent également une approche nouvelle de la recherche d'informations : la recherche conversationnelle.

Avec ce concept, chercher une information ressemble aux échanges entre humains pour obtenir une information : vous posez une question à une personne, qui cherche à comprendre ce que vous cherchez exactement en tenant compte du contexte. Si la personne a besoin de précisions, elle peut vous répondre en vous demandant d'apporter des infos complémentaires. Et ainsi de suite, jusqu'à ce que vous obteniez ou non une réponse.

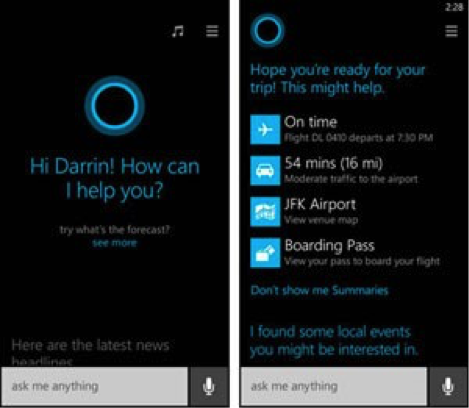

La recherche vocale de Google permet déjà la recherche conversationnelle. Mais c'est surtout dans les assistants personnels comme Cortana, Alexa, ou Google Assistant que l'on trouve ce mode de recherche. Et là aussi, la recherche conversationnelle demande un fonctionnement en mode moteur de réponses quasi absolu.

Fig.8. Cortana, l'assistant de Microsoft, comprend vos questions en langage naturel et est capable, comme Google Now, de vous envoyer les informations dont vous avez besoin quand vous en avez besoin (comportement « prédictif »). L'usage de Cortana sur Windows 10, qui effectue des recherches sur Bing pour vous si votre question le demande, a fait progresser l'usage de Bing de manière spectaculaire.

Les agents conversationnels risquent d'enfoncer un clou supplémentaire dans le modèle à base de mots clés. Et nous risquons de voir ces agents évoluer vers des agents de plus en plus intelligents. Or ces agents risquent de se substituer aux internautes pour effectuer des requêtes sur les outils de recherche du futur. Par exemple, une partie de la croissance des parts de voix de Bing trouve son origine par les requêtes effectuées par … Cortana, sur les machines équipées de Windows 10.

Les agents intelligents

A quoi ressemblera un agent intelligent demain ? Ce sera un outil capable de faire des recherches, ou de réaliser des actions (commander une pizza ?), en arrière plan. Mais capable aussi d'effectuer des actions de manière prédictive, à la manière de Google Now, en partant de la connaissance acquise grâce à l'analyse de l'historique de vos recherches et de vos actions, et d'autres applications comme votre agenda, votre boîte mail.

Fig.9. Google Duplex, un assistant expérimental capable de prendre rendez-vous chez le coiffeur tout seul à votre place, en entretenant une conversation en langage naturel au téléphone avec le coiffeur, est une préfiguration des agents intelligents de demain.

Google enverra-t-il moins de trafic ?

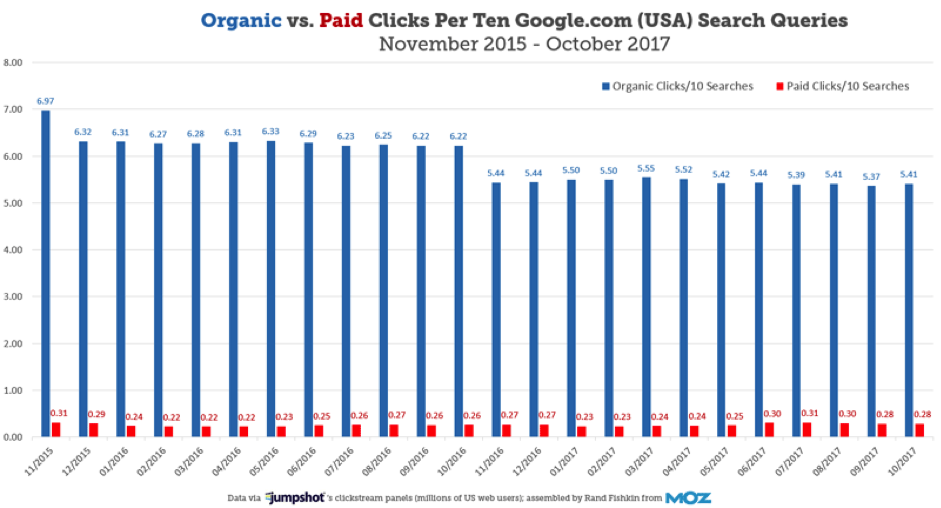

Si on regarde les statistiques fournies par les outils de panel, le volume de trafic envoyé par le moteur de recherche aux autres sites a reculé, peut-être pour la première fois depuis le lancement du moteur !

Fig.10. Données de Jumpshot, citées par Rand Fishkin de Moz : la part de clics renvoyant vers d'autres sites depuis les pages de résultats de Google est en baisse constante. C'est particulièrement net sur mobile.

Depuis quelques années, avec le développement des boxes, des quick answers, du knowledge graph, des featured snippets etc., la proportion du trafic reçu par Google renvoyé vers d'autres sites connaissait une érosion régulière. Mais comme le nombre de requêtes adressées à Google augmentait plus vite que cette érosion, l'écosystème continuait de bénéficier d'une « manne » en croissance permanente.

Si le phénomène constaté fin 2017 se poursuit, cela signifie que Google conservera une grande partie du trafic capté par son moteur pour lui-même, et que la part du Search dans le trafic des sites restera forte dans les prochaines années, mais en décroissance !

Cette nouvelle donne peut changer beaucoup de choses : peut-être l'abandon du Search pour certains, ou une rationalisation de l'approche pour accéder à une ressource en raréfaction de l'autre.

Les modes alternatifs de recherche : la recherche visuelle

En parallèle, on voit apparaître de nouveaux outils de recherche exploitant les progrès en matière de reconnaissance visuelle.

Selon moi, la recherche visuelle s'ajoutera, et ne se substituera pas, à la recherche d'informations classique. Mais elle risque de représenter à terme une opportunité nouvelle pour rendre visible des marques ou des produits. Les technologies sont là, les premières applications aussi. Les premiers résultats montrent que l'adoption de ce mode de recherche prendra du temps. Pour rendre ce mode de recherche parfaitement fluide et facile à employer, il faudra peut-être que des outils comme les Google Glass se démocratisent.

Fig.11. Google Lens : la dernière application de recherche visuelle signée Google.

Personal, Pervasive, Predictive

En conclusion, nous sommes arrivés à un moment où la recherche traditionnelle, c'est-à-dire le fait de fournir une page de résultats contenant 10 liens bleus en réponse à la frappe d'une expression clé, va vite être en perte de vitesse. Et elle sera remplacée par de multiples approches : de nouvelles interfaces de recherche et de nouvelles façons de faire de la recherche.

Pour reprendre une expression popularisée par les équipes de Bing, les moteurs de recherche du futur seront « personal, pervasive, predictive ». C'est-à-dire capable d'effectuer des recherches personnalisées, en mode conversationnel (personal), avec des outils de recherche omniprésents dans votre environnement (dans votre voiture, votre maison, votre bureau etc…), et capables d'anticiper vos questions avant que vous songiez à les poser !

Quel avenir pour les référenceurs ?

Face à une telle accumulation de changements technologiques, est-ce que le SEO sera toujours le même dans cinq ans ?

Oui et non.

Pour ceux qui se spécialisent déjà dans le référencement technique, les sujets demandant une expertise technique vont selon moi se multiplier. Cette expertise va être de plus en demandée. Même chose pour les content marketers.

Ceux qui font de l'optimisation On Page (optimiser des balises SEO, créer des pages d'atterrissages optimisées etc…) pourront encore exercer leur art sur le Google du futur proche. La firme de Mountain View fait évoluer les fonctionnalités de son moteur très progressivement, mais très sûrement aussi. La question sera : est-ce que le ROI de ce type d'optimisation, est-ce que leur pertinence et leur efficacité sera toujours aussi grande qu'aujourd'hui ? Personnellement, je ne pense pas.

Messieurs les référenceurs, il faut donc vous préparer à un changement d'époque, un changement de technologie, un changement du concept de recherche d'information.

Un certain nombre de professionnels du secteur ont déjà un bagage culturel (technique et marketing) très vaste, qui leur permettra de s'adapter à la nouvelle donne.

D'autres vont sans doute être confrontés à une révision déchirante de leurs certitudes…

Il me parait en tout cas clair que pour optimiser sa visibilité dans un moteur demain, il vaudra mieux savoir ce que sont Tensor Flow et les réseaux de neurones… Le référencement dans cinq ans intégrera déjà des outils, des approches, des stratégies issues de l'intelligence artificielle.

Faut-il le regretter : je ne le pense pas. C'est au contraire une opportunité formidable pour ceux qui sauront être créatifs et inventifs.

Vivement demain !