L’évolution du numérique nous emmène à réfléchir à l’avenir du SEO et à sa mutation progressive vers de nouvelles technologies. La montée en puissance des objets connectés, et notamment des enceintes intelligentes et assistants vocaux, pousse les spécialistes à s’intéresser au SEO vocal, mais aussi aux méthodes pour répondre présent au sein de ces outils d’avenir. De nombreuses études tentent d’expliquer que d’ici 2020, plus de 50% des recherches seront effectuées vocalement, alors prenons les devants…

Par Mathieu Chartier

Par Mathieu ChartierAbondance a déjà 20 ans, l’imaginez-vous ? En deux décennies, nous sommes passés de la version beta de Google à Google Home et une multitude de services que nous ne pouvions même pas imaginer naguère, hormis dans les films de science-fiction. Remercions donc Abondance et Olivier Andrieu pour tout ce qu’il a apporté à la communauté et au SEO en général, et démontrons que nous devons continuer à vivre et travailler avec passion. Parler de SEO vocal et notamment des skills (actions) est donc une approche très intéressante qui démontre pleinement le bond en avant effectué par le Web et le numérique. Allons-y ! 😉

Le contexte du SEO vocal en 2018

Le SEO vocal est une continuité évidente de la recherche textuelle classique, si ce n’est qu’elle est menée à la voix grâce aux progrès technologiques des dernières années. Certes, parler à notre smartphone dans la rue ne nous rend pas toujours très malins, mais ce genre de phénomène risque fort de devenir monnaie courante. Que ce soit par le biais d’objets connectés en tout genre, de smartphones ou des assistants vocaux, parler pour effectuer une recherche va devenir un réflexe qui ne choquera sûrement plus grand monde d’ici quelques années.

Mais alors, nous sommes en droit de nous demander ce qui change en matière de SEO. En effet, le SEO vocal représente une retranscription littérale de ce que les objets perçoivent par des sons. Des algorithmes viennent calculer et analyser les dires de chacun pour en faire des phrases compréhensibles qui deviendront des requêtes. En soi, ce sont donc des requêtes classiques en définitive, si ce n’est que nous pouvons quasiment assurer qu’il ne s’agira que de requêtes conversationnelles ou de questions précises. En effet, il est bien difficile d’imaginer quelqu’un parler à son smartphone et dire : « abondance anniversaire 20 ans ».

Ajoutons à cela que les requêtes parlées seront autrement plus complexes et de « longue traîne » que les quelques mots clés que nous avons pris l’habitude de taper. Par conséquent, ne voyons pas le SEO vocal comme une simple retranscription "bête et méchante" de termes associés, mais bel et bien comme une opportunité de progresser sur les requêtes conversationnelles.

Les skills et actions, c’est quoi au juste ?

De récentes études ont démontré que les américains (notamment) souhaitent effectuer des actions par la voix, mais dans de nombreux cas, les fonctionnalités basiques des assistants tels que Google Home, Apple Homepod, Microsoft Cortana ou Amazon Alexa (Echo) peinent à répondre à ces besoins (source : https://goo.gl/WLikXc). De ce fait, les ingénieurs ont réfléchi et développé un système d’actions (ou « skills ») qui permettent de répondre à des demandes précises, sous forme de petites applications créées sur mesure.

En soi, nous pourrions presque parler de « vocalBot », à l’image des chatBots tant décriés mais pourtant pas si éloignés que cela de ces programmes. En effet, les skills correspondent à des réponses et fonctionnalités préétablies au sein des assistants vocaux. Cela ressemble en tout point à des chatBots qui répondent eux aussi à des demandes particulières, si ce n’est que la voix prend le relais dans ces « vocalBots ».

À ce jour, les quatre grands acteurs du marché de l’assistance vocale ont mis en place des outils de développement d’actions et d’applicatifs :

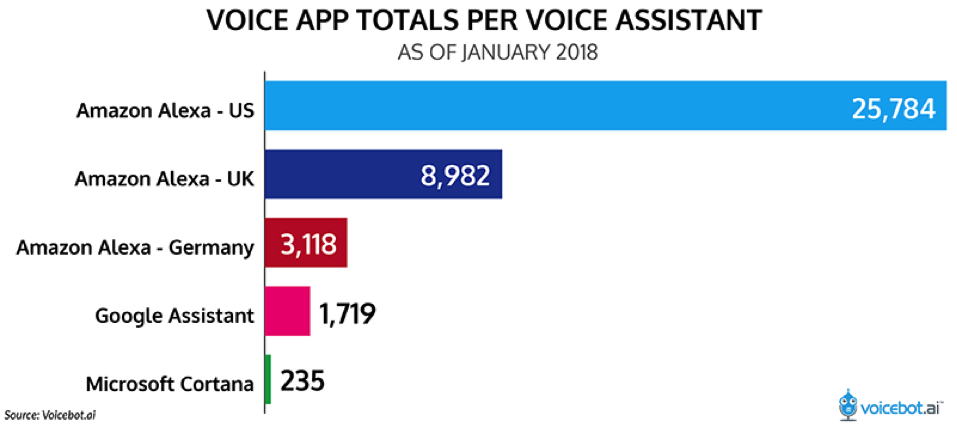

- L’Alexa Skills Kit d’Amazon (source : https://goo.gl/J1pTLF) est le plus fourni en applications puisque nous dénombrons déjà près de 30 000 ASK (source : https://goo.gl/1mwrmi), dont plus de 10 000 ASK créés sur le dernier trimestre 2017.

- Google tente de rattraper son retard sur Amazon avec les actions de Google Home et un kit de développement dédié (source : https://goo.gl/5KiJGJ). Son catalogue est assez fourni puisque nous pouvons déjà compter près de 9 000 actions.

- Microsoft dispose aussi de skills pour Cortana et d’un kit de développement dédié (source : https://goo.gl/yirRVc). À l’heure d’écrire ces lignes, 236 Cortana skills ont été développées en provenance de grandes marques telles que Spotify, Expedia, Philips Hue, Domino’s Pizza…

- Apple a également lancé son Sirikit (source : https://goo.gl/bdMQAR) pour suivre la tendance, mais est encore en retrait car l’Homepod est le dernier né des quatre assistants vocaux cités ici.

Fig. 1. Répartition des parts de marché des skills (actions) par marque.

La logique des skills reprend celle des objets connectés de chaque marque. En effet, les parts de marché sont encore nettement en faveur d’Amazon Alexa (via Amazon Echo et dérivés) mais Google Home remonte en flèche depuis sa commercialisation plus généralisée. Microsoft est en retrait et Apple encore tout jeune, mais certains spécialistes pensent que d’ici 2020, plus de 75% des foyers américains seront dotés d’enceintes intelligentes.

Fig. 2. Répartition des parts de marché des assistants vocaux intelligents.

Retenons également la dynamique qui accompagne le développement des applications pour assistants vocaux. Sur le dernier trimestre, les marques en retrait telles que Google et Microsoft ont vu le nombre de skills doubler, voire tripler. Il faut donc imaginer que ces vocalbots ont encore de beaux jours devant eux… Dans notre cas nous allons cibler notre intérêt sur les actions de Google. Non pas que les autres marques nous désintéressent, mais nous savons que Google a une volonté de recherche (et donc de SEO vocal) bien plus développée que ses concurrents, et il nous semble donc cohérent de rester fidèle à notre besoin de spécialiste du référencement. 🙂

Où et comment développer une action pour Google ?

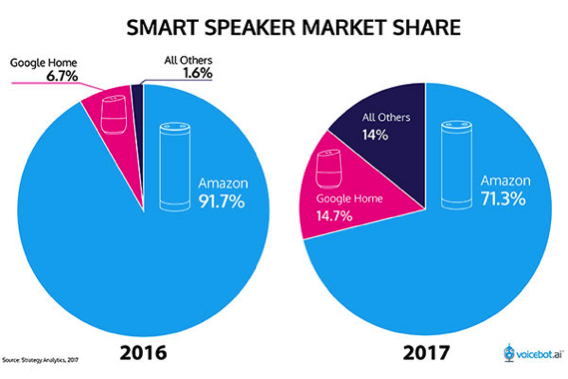

Pour commencer, il est fortement recommandé de lire un peu de documentation avant de se lancer à l’aventure dans le grand bain de la création de skills. Google et consorts ont bien entendu pensé aux développeurs en ce sens (source : https://goo.gl/5KiJGJ). Dans un second temps, vous devez vous connecter à l’Actions Console de Google (https://console.actions.google.com), directement liée à des projets provenant de la console pour API du moteur de recherche (source : https://goo.gl/KoNajg).

Fig. 3. Importez un projet dans l’Action Console de Google.

Importez un projet dans l’Actions Console et vous aurez ensuite accès à toutes les fonctionnalités relatives aux actions. Google propose quatre possibilités intéressantes :

- l’API DialogFlow (ex api.ai) pour créer des interactions avec un assistant vocal ;

- Smart Home pour créer des applications permettant de piloter des appareils IoT (objets connectés) via l’assistant de Google ;

- Le SDK Actions pour créer des actions localement sur votre machine ;

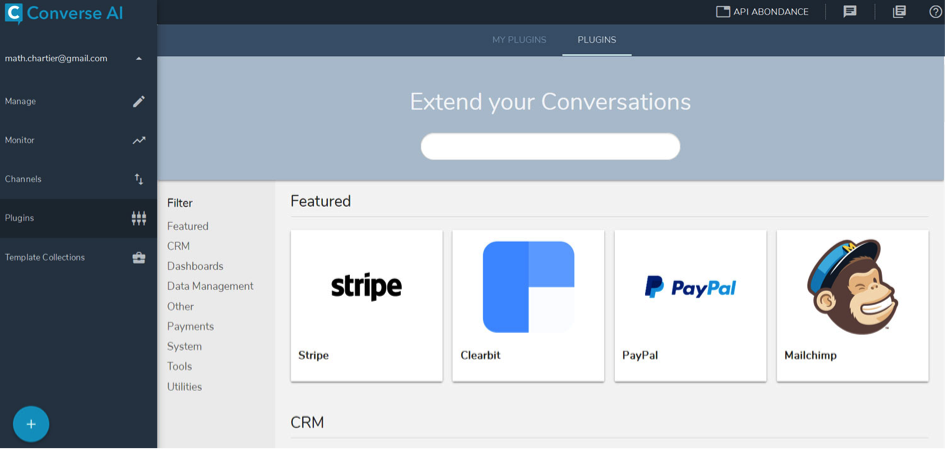

- Converse.ai pour concevoir des discours et actions pour l’assistant sans mettre les mains dans le code (mais c’est aussi un peu plus limité).

Les concepteurs de ChatBots peuvent aisément se retrouver à l’aise car les grands principes déjà connus sont repris. L’avantage est d’avoir en main des outils comme Converse.ai qui évitent aux moins aguerris d’entre nous de développer un VocalBot (et ses skills), à l’instar de ce que fait très bien ManyChat pour les ChatBots par exemple. Converse.ai possède de nombreux plugins préinstallés (paiement en ligne, envoi d’emails, etc.) ainsi que des templates d’exemples afin de s’inspirer de ce qui a déjà été fait. Nul doute que vous devez tester cette plate-forme clé en main si le SEO vocal vous passionne. Notons que l’API DialogFlow, bien que basée sur du Javascript, permet de concevoir également un bot sans forcément passer par le code…

Fig. 4. De nombreuses fonctionnalités présentes dans Converse.ai.

Concevez votre première action pour Google Home avec DialogFlow…

Si vous préférez créer une action par un développement web classique, alors il est fortement conseillé de bien maîtriser Javascript et d’observer les quelques exemples fournis par Google (https://developers.google.com/actions/samples/). Parmi ceux-ci, nous retrouvons même une transcription vocale du ChatBot Eliza, le premier du nom créé en 1966, c’est dire si la corrélation entre les diverses technologies est perceptible. Toutefois, nous pouvons aussi réaliser un VocalBot sans mettre la main dans le code, donc profitons-en… 🙂

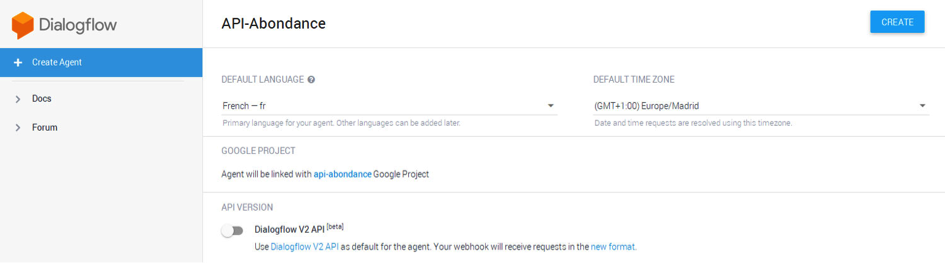

Vous devez vous inscrire à l’API DialogFlow via l’Actions Console de Google. C’est très simple et vous vous retrouverez très rapidement à paramétrer votre projet, comme le montre la figure 5. Dans un premier temps, il convient de définir des intentions de recherche (intents) pour mener des actions particulières. Cela consiste à passer par Google avec des actions telles que « OK Google, parle de Google », ou par des intentions ciblées sur l’application comme « demande à Abondance son année de naissance ». De toute évidence, il faut alors préciser le nom de l’application et l’action à effectuer (source : https://goo.gl/Lf1yoS).

Fig. 5. Création d’un projet dans l’API DialogFlow.

Quelle que soit l’application, vous devez tout d’abord définir l’action d’accueil, c’est-à-dire la phrase qui va lancer le programme ou la requête recherchée. Pour ce faire, Google a mis en place un événement appelé GOOGLE_ASSISTANT_WELCOME. C’est très simple à créer, vous devez cliquer sur l’onglet de menu « Intents », puis créer une action ou utiliser l’action intitulée « Default Welcome Intent » (recommandé). Il ne vous reste qu’à indiquer la phrase qui va lancer le programme vocal (ici, « Salut Abondance » par exemple) et paramétrez la réponse attendue.

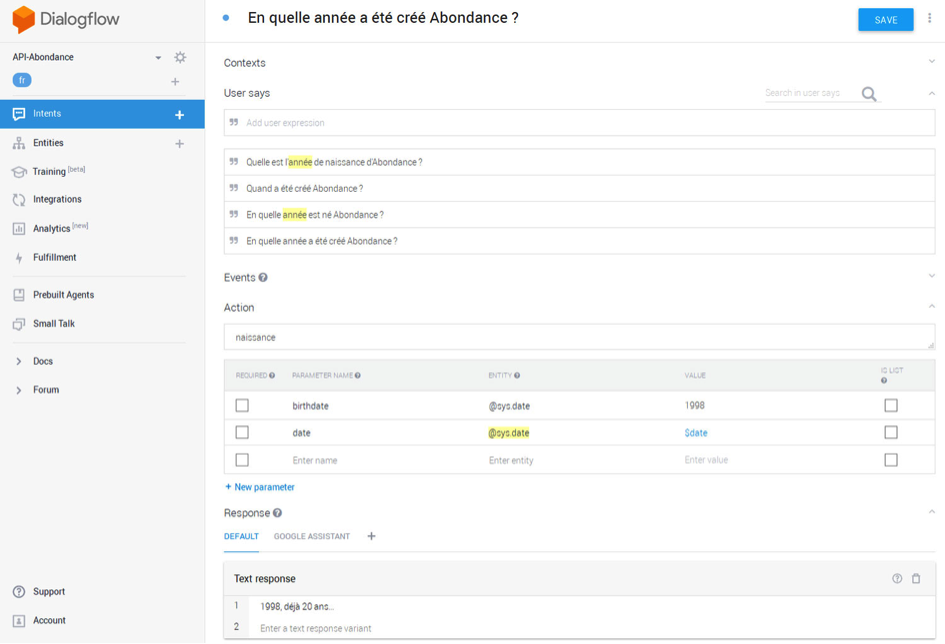

Google parle bien d’intentions de recherche (intents) et non de questions ou de phrases. La nuance est importante. En effet, nous soumettons à Google des intentions afin que l’IA puisse intervenir et imaginer des variantes. Par exemple, si nous souhaitons connaître les ingrédients pour une recette de crêpes, il peut exister de multiples manières d’invoquer l’assistant vocal. En proposant quelques variantes d’intentions, nous aidons donc Google à mieux comprendre ce que nous évoquons, et l’assistant pourra parfois répondre à des phrases que nous n’avions même pas prévu à l’origine…

Pour faire simple, DialogFlow propose deux intentions par défaut :

- Default fallback intent : réponse de l’assistant s’il n’arrive pas à comprendre la phrase de l’utilisateur.

- Default welcome intent : phrase de bienvenue qui va lancer tout le process du VocalBot.

Nous ne pouvons pas aller très loin avec ces premières intentions, et il est important de créer des scenarii de dialogue si nous souhaitons créer une application complète et intelligente. Dans notre exemple ici, nous n’irons pas trop en profondeur, mais l’idée est que vous puissiez comprendre les concepts et les principes de création d’un VocalBot.

Créer une action personnalisée

Pour pouvoir créer des applications plus puissantes, il peut être intéressant de créer des entités (entities) et des intentions personnalisées. En effet, le message d’accueil ne suffit pas pour proposer des fonctionnalités avancées.

Les entités peuvent facilement être créées, et plus vous en avez, plus l’application est complète et permet de répondre à des demandes spécifiques. Pour ce faire, il suffit de cliquer sur l’icône « + » située à côté de l’onglet « Intents ». Vous pouvez donner un nom à l’entité, spécifier plusieurs phrases, questions ou mots qui peuvent déclencher l’action, et ajouter potentiellement des paramètres. La figure 6 montre comment créer une action simple. Ici, nous évoquons l’année de naissance d’Abondance et nous ajoutons des paramètres de réponse avec du texte « 1998, 20 ans déjà… ».

Fig. 6. Création d’une intention simple.

Si vous souhaitez obtenir plus de variantes de réponses, cela va dépendre de l’assistant sélectionné. Par défaut, vous ne pouvez créer que des réponses textuelles simples, mais si vous optez par exemple pour « Google Assistant » ou « Facebook Messenger », vous avez de nombreuses autres possibilités, telles que des listes (menu), des liens, des carousels. C’est ainsi que vous pouvez enrichir votre VocalBot.

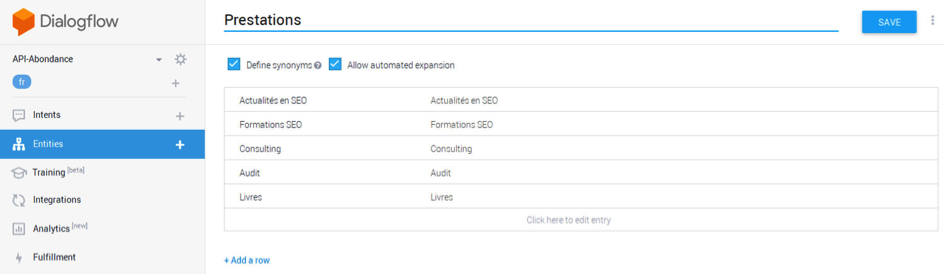

Pour aller plus loin : les entities, contexts et fulfillments…

Les entities correspondent à des listes de données qui peuvent être utiles à l’application. Ce sont des paramètres que peut récupérer l’application à la volée, comme des mots clés particuliers. DialogFlow contient déjà des entités préinstallées, mais nous pouvons en créer nous-même. Par exemple, il est possible de récupérer des dates à la volée lors d’un échange vocal, ou tout autre notion. Pour l’occasion, nous avons créé une liste de prestations que peut fournir Abondance (voir figure 7) et nous pourrions l’utiliser pour réagir en fonction de ce qui est dit par l’utilisateur, etc.

Fig. 7. Création d’une entité personnalisée.

DialogFlow propose également des Contexts, c’est-à-dire des sortes de liaison entre diverses actions. Le contexte permet à l’API de comprendre comment deux entités sont liées entre elles. Par exemple, si vous évoquez un livre rédigé par Olivier Andrieu dans un premier temps et que vous demandez au Bot « date de publication de ce livre » sans lui préciser quel ouvrage est visé dans un second temps, le contexte permet de déterminer de quel livre l’assistant doit donner la date de publication. C’est ainsi que nous pouvons rendre plus « naturelles » les conversations.

Si vous devez aller plus loin en passant par des programmes personnalisés, il faudra alors passer par du code Javascript et la case « Fulfillment ». La documentation permet de faire ses premiers pas dans ce jargon spécifique à DialogFlow (source : https://goo.gl/wxWd1B). Les réalisations (fulfillement) peuvent être simples à paramétrer via Node.JS ou directement dans l’éditeur en ligne que l’on trouve dans la section « Fulfillment » du menu. Ici, vous pouvez programmer des questions/réponses pour l’assistant directement via l’API DialogFlow en Javascript. Ce n’est pas forcément simple à prendre en main tant la documentation se contredit (car elle n’est pas mise à jour entre l’ancien api.ai, DialogFlow v1 et v2…) et c’est aussi bien plus compliqué car il faut tester en continu pour s’assurer que tout ce que l’on programme est fonctionnel.

En tout cas, si vous activez un WebHook (code que l’on importe) ou l’éditeur en ligne (Inline Editor) dans Fulfillement, vous obtenez une nouvelle section appelées « Fulfillment » au sein des « intents ». Cochez la case « Use Webhook » pour pouvoir utiliser votre code personnalisé en lieu et place des réponses classiques proposées dans l’interface de DialogFlow. Ainsi, les fonctions que vous pouvez programmer peuvent s’appliquer aux intentions dont la case est cochée, et vous donne une pleine liberté de création.

Rappelons que la création de fulfillments est purement optionnelle. Certes, c’est ce qui donne beaucoup plus de poids à une application. Nous pourrions très bien récupérer des flux RSS externes par exemple, obtenir les derniers tweets relatifs à une entreprise, etc. Nous pouvons réellement créer des applications vocales abouties via ce système, mais cela demande bien plus de compétences en Javascript…

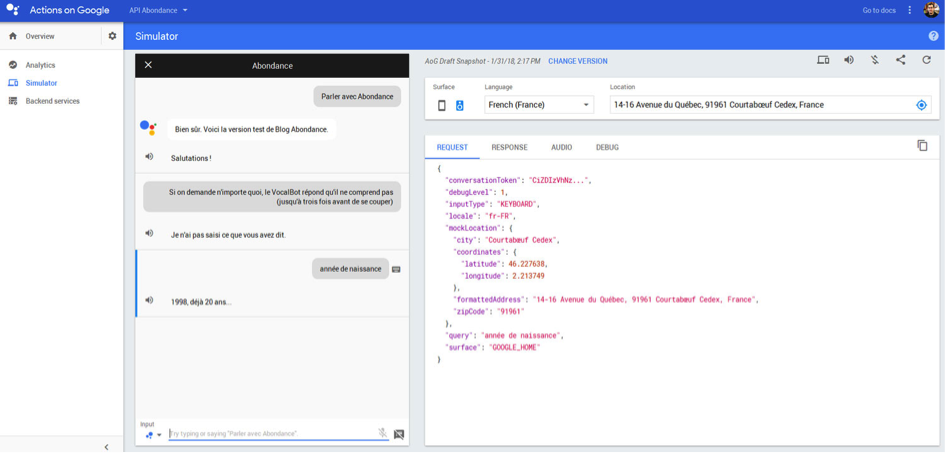

Tester l’application (VocalBot) par clavier ou à l’oral

Lorsque vous aurez mis en place toutes vos actions et phrases, vous devrez tester l’application à l’aide du simulateur proposé par Google. Il est disponible directement dans l’Actions Console ou en cliquant sur le lien « See how it works in Google Assistant » affiché sur la droite dans DialogFlow. Vous pouvez bien entendu tester l’application en tapant avec un clavier ou même en utilisant votre smartphone avec un microphone, ou Google Home, etc. Notez que le simulateur n’est pas une franche réussite sur smartphone tant le responsive design laisse à désirer, mais les tests fonctionnent tout de même.

La figure 8 montre un exemple de test des quelques actions que nous avons réalisées pour l’exemple de cet article.

Fig. 8. Test de l’application dans le simulateur de l’Actions Console de Google.

Construire un véritable assistant vocal peut s’avérer très complexe et long, à l’image des meilleurs ChatBots, mais vous avez au moins ici les bases pour vous lancer dans l’aventure et penser au SEO vocal de demain. Il ne vous reste qu’à publier votre application pour pouvoir la partager sur la Toile… Vocalement, bien sûr ! 🙂

Mathieu Chartier

Consultant-Formateur et webmaster indépendant, Internet-Formation (https://www.internet-formation.fr)

de nous rejoindre

de nous rejoindre