Les techniques d’A/B testing permettent d’évaluer, entre plusieurs variantes, quelle est celle qui est la plus efficace et qui remplit le mieux possible les objectifs établis au pralable. Ce type de stratégie est-il possible en SEO pour tester plusieurs versions d’optimisations ? Et, d’un autre côté, comment faire de l’A/B Testing « classique » sans nuire à son référencement naturel et à sa visibilité sur Google ? Réponses…

L’A/B Testing est une méthode très pratique pour juger l’efficacité d’un changement. Très utilisé en e-mailing, pour du graphisme ou encore pour analyser des Landing Pages, l’A/B Testing permet d’améliorer ses conversions. On peut ainsi tester des changements de boutons, de titres, etc. Mais peut-on faire cela en référencement naturel ? Et quelles sont les bonnes pratiques à suivre ? C’est à ces questions que nous allons tenter de répondre dans cet article.

Qu’est-ce que l’A/B Testing ?

L’A/B Testing est une méthode qui consiste à tester plusieurs variantes d’un même élément auprès de ses visiteurs ou utilisateurs. Par exemple, on peut tester différentes couleurs d’un même bouton « Ajouter au panier » ou du titre d’un e-mail. Cela peut donc s’appliquer à tous les aspects du Web (e-mails, site web, design, contenus, applications, etc.) pour lesquels des utilisateurs seront soumis à des tests afin de choisir la version la plus efficace de ce que l’on teste.

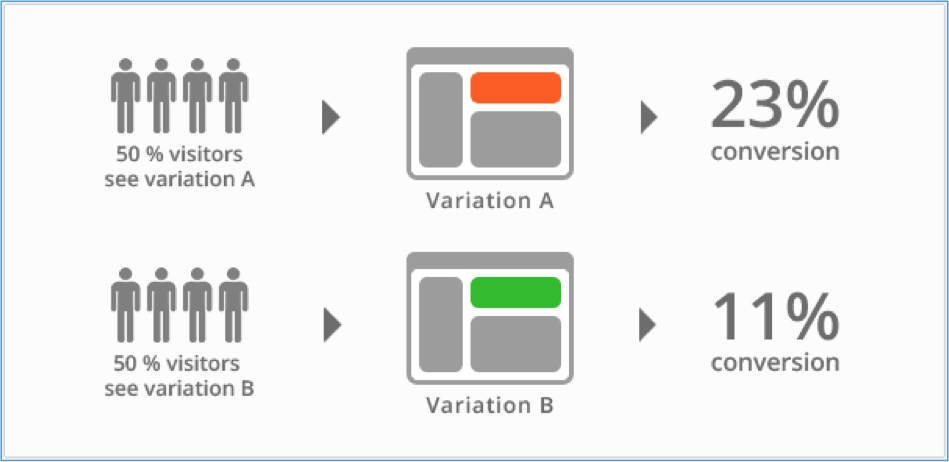

Aussi appelé Split-Testing, l’A/B Testing permet théoriquement d’améliorer ses résultats. En testant 2 variantes d’un même élément, on va essayer de trouver celle qui aura le meilleur impact sur les conversions et sur l’expérience utilisateur. Souvent, 50% des utilisateurs verront la page d’origine et 50% verront sa variante.

Fig. 1. Les visiteurs sont répartis en deux groupes afin de tester deux variations.

Source image : https://vwo.com/ab-testing/b

L’objectif est de valider ou non les hypothèses que l’on a, comme par exemple :

- Cette formulation est-elle plus percutante ?

- Ce design incite-t-il à l’achat ?

- Cette interface augmente-t-elle le nombre de pages vues des lecteurs ?

- Etc.

Comment faire de l’A/B Testing ?

Avant de parler des aspects liés au référencement naturel, il est crucial de comprendre comment fonctionne réellement un test A/B, notamment car cela peut avoir un impact réel sur vos décisions. Un test A/B mal conçu peut ainsi vous faire prendre la mauvaise décision et vous induire facilement en erreur.

Définir des objectifs et des hypothèses

La première étape est on ne peut plus simple : il faut déterminer une hypothèse que l’on veut tester. En d’autres termes, quel critère veut-on évaluer précisément ? Quel est l’élément que l’on veut mesurer ? Quand on choisit de contrôler un élément précis, il faut émettre des hypothèses et déterminer sur quels critères nous allons les évaluer. Prenons plusieurs exemples concrets (et simplistes) :

- Site e-commerce :

- Hypothèse de départ : la couleur du bouton « Ajouter au panier » peut influer sur les ventes ;

- Hypothèses à tester : un bouton rouge, un bouton vert et un bouton bleu ;

- Objectifs : mesurer le taux de conversion et/ou le taux d’ajout au panier.

- Site de presse :

- Hypothèse de départ : la longueur des phrases a un impact sur la lisibilité des articles et donc sur l’expérience utilisateur ;

- Hypothèses à tester : avoir des design où les lignes font respectivement 60, 80 et 100 mots de long avant de passer à la ligne ;

- Objectifs : mesurer le temps passé moyen et/ou le nombre total de pages vues.

Daniel Roch

Consultant WordPress, Référencement et Webmarketing chez SeoMix (http://www.seomix.fr)

![Copyright Trolling en France : comprendre et contrôler les abus d’une pratique controversée [Partie 2] - Stéphanie Barge](https://www.reacteur.com/content/uploads/2024/05/2024-05-reacteur-stephanie-barge.png)

![Copyright Trolling en France : comprendre et contrôler les abus d’une pratique controversée [Partie 1]- Stéphanie Barge](https://www.reacteur.com/content/uploads/2024/04/2024-04-reacteur-stephanie-barge.png)