Le réseau Internet est un énorme consommateur d’énergie et pose donc des problèmes en termes de développement durable. En cela, le SEO est également partie prenante des soucis que pose le réseau au niveau écologique et il nous faudrait peut-être parfois mieux appréhender nos méthodologies au quotidien pour améliorer la situation et apporter notre brique à l’édifice pour que la Terre se porte mieux dans les années qui viennent. Voici donc un article sur l’impact écologique du SEO sur notre planète…

Par Daniel Roch

Par Daniel RochSans que l’on s’en rende réellement compte, le Web mondial a un impact fort sur l’environnement. Les moteurs de recherche et nos actions en référencement naturel ont donc malheureusement un impact négatif sur l’écologie mondiale (pollution, production d’électricité, émission de CO2, etc.). Mais est-ce si néfaste que cela ? Et que faire pour réduire notre impact écologique lorsqu’on fait du SEO ? C’est ce que nous allons voir dans cet article.

C’est quoi le développement durable ?

Commençons tout d’abord par une définition : de quoi parle-t-on quand on évoque le développement durable ? Le site de l’INSEE le définit ainsi : le développement durable est « un développement qui répond aux besoins du présent sans compromettre la capacité des générations futures à répondre aux leurs. » L’idée sous-jacente est souvent économique : quand on entre dans une optique de développement durable, on parle en réalité d’un développement économique qui préserve l’environnement. Internet et les moteurs de recherche n’en sont donc pas exclus, loin de là.

Pourquoi le web a-t-il un impact sur l’écologie ?

Le référencement naturel va agir sur notre environnement et notre planète. Pour bien comprendre cela, il faut tout d’abord prendre conscience de ce que le numérique et Internet représentent réellement :

- Si le web était un pays, il serait le 3ème plus gros consommateur d’électricité au monde.

- Il consommerait 1500 terawatts/heure par an, derrière la Chine et les Etats-Unis (source).

Juste pour avoir un ordre d’idée de ce que représente ce chiffre, un terawatt/heure, c’est 1012 watt/heures, soit 1 milliard de KW/heure. Nos sites web, les utilisateurs et les moteurs de recherche ont donc une consommation électrique très forte, dont les sources sont diverses (nucléaire, éolien, charbon, solaire, gaz).

Mais l’impact écologique vient aussi des différents aspects du fonctionnement du web, depuis la source jusqu’à l’utilisateur final :

- La fabrication et la maintenance des machines qui servent à indexer le web et à fournir un résultat à l’utilisateur ;

- La consommation électrique de ces serveurs et datacenters (fonctionnement en continu, mais aussi une climatisation massive pour les refroidir) ;

- Tout le matériel et l’électricité qui servent à transférer les données de chaque page web d’un point A à un point B ;

- Les terminaux utilisés par les internautes (PC fixes et portable, téléphones, tablettes, montres et enceintes connectées).

Tout cela va influer sur la consommation d’énergie, mais également sur les ressources naturelles nécessaires pour fabriquer chaque élément (avec des ressources non renouvelables pour certaines d’entre elles).

L’impact des moteurs de recherche

La consommation électrique

Si l’on prend uniquement les moteurs de recherche, ils représentent une forte part de l’impact écologique d’Internet. Par exemple en 2015, Google consommait 5,7 térawattheures, soit l’équivalent de la consommation de la ville de San Francisco sur un an (source).

Les émissions de CO2

Selon certaines études, Google représenterait 40% de toutes les émissions de CO2 sur Internet au monde, notamment à cause de ses nombreux datacenters et de la climatisation nécessaire à leur bon fonctionnement (source).

Les sources d’énergie

Au-delà du chiffre colossal de consommation électrique, on peut aussi se poser la question de la provenance de l’énergie. En 2017 selon Greenpeace, Google utilisait encore 15% de charbon, 14% de gaz et 10% de nucléaire, trois ressources dont l’impact écologique négatif et/ou le traitement complexe des déchets n’est plus à démontrer (source).

Les interfaces des moteurs de recherche

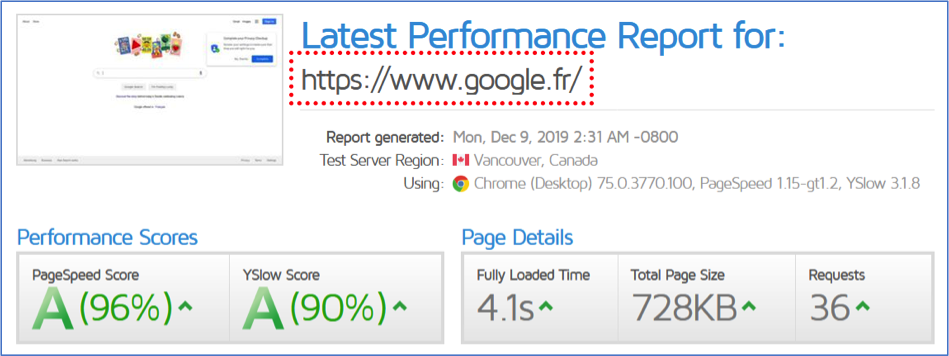

D’ailleurs, sans même parler du stockage des données ou des recherches effectuées par les internautes, la conception même des interfaces des moteurs peut avoir un impact. Si l’on regarde le poids et le nombre de requêtes des pages d’accueil de chaque moteur, on se rend compte que certains sont bien plus écologiques (et performants) que d’autres :

- Google : 36 requêtes, 0,7 Mo ;

- Yahoo : 268 requêtes, 1,7 Mo ;

- Bing : 96 requêtes, 3,4 Mo ;

- DuckDuckGo : 24 requêtes, 0.3 Mo (c’est le moteur le plus léger en ce qui concerne la page d’accueil) ;

- Qwant : 32 requêtes, 1,5 Mo.

Fig. 1. Un exemple de test du temps de chargement de la page d’accueil de Google

Par le terme « requêtes », il faut comprendre « fichiers téléchargés par le navigateur ».

L’impact des utilisateurs

Une autre problématique vient s’ajouter à celles déjà évoquées sur les moteurs de recherche : vous !

La façon dont l’internaute va consommer le Web va forcément impacter les différentes notions liées au développement durable : plus vous ferez de recherches et plus vous lirez de contenus différents, plus les besoins en électricité et en matériel vont augmenter, tout comme vos émissions de CO2.

Toutes les heures, on estime à plus de 140 millions le nombre de recherches effectuées sur Google (donc sans compter celles des autres moteurs de recherche qui existent). Sachant qu’un chercheur d’Harvard estime à 7gr de CO2 chacune d’entre elle, cela correspond donc à 980 tonnes de CO2 par heure, soit 980 aller/retour en avion Paris-New York (source https://www.fournisseur-energie.com/internet-plus-gros-pollueur-de-planete/).

En réduisant le nombre de nos recherches, on pourrait tous faire baisser drastiquement ce chiffre. Il faudrait par exemple :

- Cibler mieux nos recherches ;

- Taper directement le nom de domaine plutôt que de le chercher sur le moteur ;

- Eliminer les recherches inutiles.

L’impact de notre site

Bien entendu, même si Google réussissait à réduire sa consommation et ses émissions, et même avec des utilisateurs avertis, le référencement et les autres aspects de nos sites vont eux aussi impacter négativement l’environnement. Cela se décompose en plusieurs volets sur lesquels nous pouvons travailler (certains exemples sont tirés de notre conférence « Une stratégie SEO propre avec WordPress » : https://www.seomix.fr/10-conseils-strategie-seo-propre-wordpress/).

Temps de chargement

Commençons par le temps de chargement. En référencement naturel, cela va permettre de travailler trois éléments :

- Mieux convertir les internautes qui viennent d’un moteur de recherche ;

- Améliorer légèrement le positionnement d’un contenu ;

- Améliorer drastiquement le crawl et l’indexation de Google.

En termes de développement durable, c’est ce dernier point qui est le plus important. Google va pouvoir ainsi réduire les ressources nécessaires pour pouvoir crawler et indexer votre site en entier.

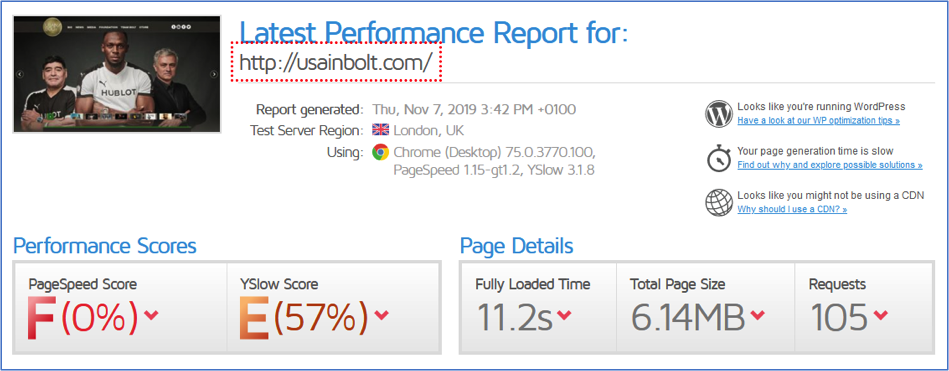

Prenons un exemple d’une personnalité célèbre qui utilise le CMS WordPress : Usain Bolt court plus vite le 100 mètres (9,58 secondes) qu’il ne met à charger la page d’accueil de son site (11,2 secondes).

Fig. 2. Le temps de chargement du site Usain Bolt : 11,2 secondes avec plus de 100 requêtes et 6Mo de fichiers à télécharger.

Avec un poids aussi élevé et autant de requêtes, il impacte fortement l’écologie : en travaillant la performance de son site, il pourrait améliorer son référencement tout en réduisant ses émissions de CO2, et en donnant également une meilleure expérience utilisateur.

Quand on teste ce même site sur un calculateur de CO2 (https://www.websitecarbon.com/), la page d’accueil émettrait 3,8Gr de CO2.

Fig. 3. La page d’accueil du site d’Usain Bolt émet trop de C02.

A titre de comparaison, celle d’Abondance.com va en émettre environ 0,7Gr.

Contenus inutiles

Second point clé lorsque l’on parle de référencement naturel, la pertinence des contenus. En soi, un contenu plus intéressant n’est pas meilleur pour le développement durable. Mais c’est justement en cherchant à améliorer cet aspect sur un site que l’on va supprimer ou fusionner toutes les publications qui n’ont pas d’intérêt (et qui polluent inutilement le web).

Parmi celles-ci, on peut citer :

- Les articles trop anciens dont le contenu n’est plus à jour ;

- Les sujets trop vieux pour être pertinents (par exemple, des tutoriels sur de très anciens logiciels) ;

- Tous les contenus peu pertinents pour l’internaute, comme dans l’exemple de la figure 4.

Fig. 4. Un exemple de contenu n’ayant pas d’intérêt mais qui « consomme » inutilement des ressources (stockage, crawl, etc.).

Un CMS ou un outil qui génère n’importe quoi

Beaucoup de sites utilisent à la base des CMS (WordPress, Prestashop, Drupal, Joomla, etc.) ou des Frameworks. Ces outils pratiques permettent d’installer et de mettre en place des sites assez facilement. Malheureusement, cette simplicité masque parfois certains aspects néfastes. Derrière tout outil, on va trouver en effet tout un tas de fonctionnalités. Certaines s’activent par défaut, sans pour autant avertir l’utilisateur. Celles-ci peuvent pourtant :

- Consommer de l’énergie pour rien ;

- Augmenter le temps nécessaire pour crawler votre site ;

- Faire perdre du temps à l’internaute (car la page est plus longue à charger).

Quel que soit l’outil utilisé, le référenceur se doit de le maîtriser car il pourra corriger ces problématiques pour réduire son impact écologique tout en améliorant son SEO.

Prenons l’exemple du CMS WordPress (35% du Web mondial) avec quelques exemples concrets d’actions ayant un impact à la fois sur le référencement naturel et sur l’écologie :

- Supprimez les contenus par défaut :

- L’article « Bonjour tout le monde » ;

- La page « Page d’exemple » ;

- La catégorie « Non Classée ».

- Fusionnez la page de politique de confidentialité que WordPress peut parfois générer avec les mentions légales classiques de votre site ;

- Pensez au temps de chargement (notamment avec WP Rocket pour la mise en cache et Imagify pour la compression des images) ;

- Supprimez dans le header tout ce qui ne sert à rien : les liens raccourcis, les liens RSD ou encore le XMLRPC ;

- Supprimez le système de Pings qui alerte Pingomatic pour rien à chaque publication ou mise à jour de l’un de vos contenus ;

- Faites attention au choix et au paramétrage de vos extensions ;

- Nettoyez votre thème en supprimant tout ce qui est inutile :

- Les liens redondants ou inutiles (celui sur les dates par exemple) ;

- Les contenus de démonstration ;

- Les fonctionnalités ou encore les widgets non utilisés ;

- Etc.

La liste n’est bien sûr pas exhaustive, mais elle vous permet de comprendre le principe même de ce qui doit être fait, quel que soit le CMS ou Framework utilisé.

Un code propre et simple

Cela nous amène encore à un autre point : la qualité du code. On parle ici à la fois du code qui permet de générer le site (par exemple avec PHP) et du rendu final du code (l’HTML et ce qui va avec).

Les problèmes PHP

Le code utilisé aura un impact sur les ressources nécessaires pour calculer et générer une page : c’est le cas quand vous cliquez sur un lien et que cela met un certain temps avant d’afficher le moindre contenu.

Plus le code PHP sera long, complexe ou non optimisé, plus il faudra de ressources pour générer le moindre contenu. Et ce sera la même problématique pour le moteur de recherche qui devra consommer davantage pour crawler et indexer chaque URL.

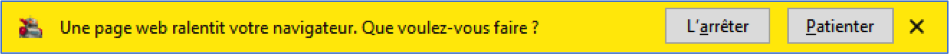

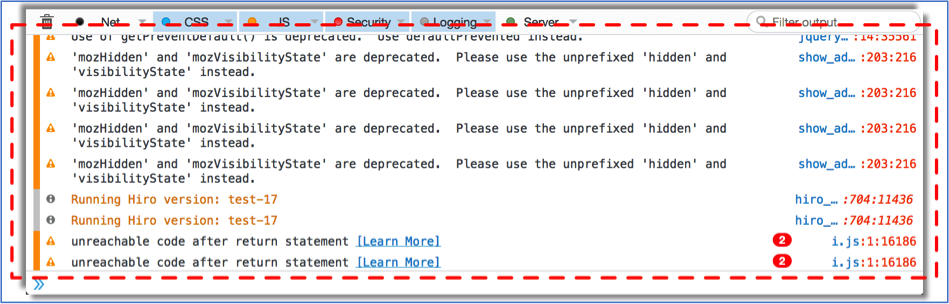

Les problèmes HTML, CSS et JS

Le poids du fichier HTML a un impact plus subtil. Tout d’abord, cela va augmenter le temps de chargement (plus le code est long, plus le poids HTML à télécharger et/ou stocker est important). Soyons honnête cependant, le poids de l’HTML est souvent assez négligeable par rapport au reste d’une page web.

Les ressources (JS, CSS) sont par contre importantes dans le rendu final est important. On va bien entendu d’abord penser au nombre de ces dernières, ce qui est parfaitement juste. Mais on oublie un autre aspect : la qualité. En effet, plus il y aura d’erreurs de code dans l’HTML, le JS ou le CSS, plus votre navigateur va devoir « compenser » pour afficher correctement la page. Il devra donc consommer un peu plus de ressources. De même, plus ces codes seront longs et complexes, plus les navigateurs web mettront du temps à les interpréter (c’est notamment le cas quand ces derniers disent qu’une page web « ralentit votre navigation »).

Fig. 5. Un exemple d’une page web lente car mal conçue.

Et ce sera identique pour tous les moteurs de recherche qui doivent analyser et comprendre les mêmes codes et qui vont se heurter aux mêmes bugs ou ralentissements.

Fig. 6. Des exemples d’erreurs dans du code JavaScript.

Et le travail du référenceur ?

Le travail de base

C’est là où l’on empire les choses : toute personne qui travaille le référencement naturel de son site va augmenter certains aspects négatifs pour l’écologie, ceci pour deux raisons simples :

- Il va rédiger de nouveaux contenus (qu’il faut stocker sur des serveurs et que Google devra crawler et indexer) ;

- Il va créer de nouveaux liens sur différents sites.

Bien entendu, il aura également au quotidien un impact positif (suppression des pages inutiles, amélioration des publications existantes, etc.).

Le référenceur « black Hat »

Au-delà de cette liste basique, certains référenceurs peuvent impacter plus que d’autres notre environnement, notamment tout ceux faisant de la génération automatique de contenus, de liens voire même de sites : on va ainsi créer, spinner, importer et publier des tonnes de contenus. Certains réseaux de sites peuvent ainsi contenir des milliers et des milliers de pages générées à la volée et sans aucun intérêt pour l’utilisateur final.

On peut également y ajouter toutes les personnes qui utilisent le piratage pour générer du contenu, du spam ou des liens. L’ancien site Spam Clock montrait d’ailleurs dès 2011 le volume énorme de pages que cela pouvait représenter (pour information l’outil n’existe plus) :

Fig. 7. Le spam web peut très vite prendre des proportions énormes (source).

Les tâches classiques du référenceur

Les référenceurs, quels qu’ils soient, ne se rendent pas compte de l’impact potentiel qu’ils ont en termes d’écologie. Pourtant, de très nombreuses actions qu’ils vont mettre en place au quotidien sont très gourmandes en ressources et également fortement émettrices de CO2. On ne parle pas ici des contenus ou des liens dont on a parlé plus haut, mais plutôt de tâches qui semblent anodines. Prenons deux exemples :

Le suivi de positionnement

Tous les référenceurs font appel à des solutions permettant de suivre souvent quotidiennement la position des mots clés de leurs clients ou de leurs sites. Cela veut dire que pour chaque mot clé suivi, nous effectuons en réalité une recherche Google.

Si vous mettez en place un suivi classique pour un site web, par exemple avec 100 mots clés suivis, cela veut dire que vous émettez :

- 700 grammes de CO2 par jour ;

- 21,3 kilos de CO2 par mois ;

- ¼ de tonne de CO2 par an.

Faites de même pour 4 sites en simultané, et vous aurez généré 1 aller/retour en avion Paris-New York par an juste avec le suivi de positionnement.

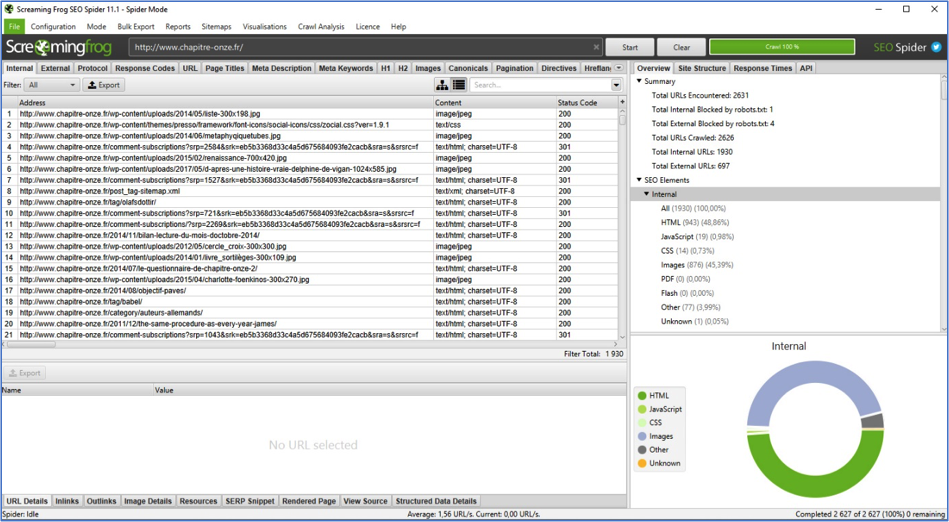

Le crawl

Autre action régulière :le crawl de son propre site (ou de celui d’un concurrent ou d’un client). Des outils comme Screaming Frog Spider SEO ou Xenu Link Sleuth vont ainsi scanner chaque URL d’un site pour en obtenir différentes informations (balises Title, pages 404, images sans textes alternatifs, et ainsi de suite).

Ce crawl va donc forcer le serveur à calculer et renvoyer les différentes pages, images et autres fichiers. Tout cela a un coût électrique, et va aussi émettre encore plus de CO2.

Fig. 8. Un exemple d’un outil de crawl (ici : Screaming Frog) ayant un fort impact sur les notions de développement durable.

Reprenons l’exemple du site d’Usain Bolt. Pour cet article, nous avons lancé un crawl de son site. Nous allons partir sur le principe que chacune de ses pages va générer le même montant de CO2, soit pour rappel 3,8Gr (certaines pages de son site font surement moins, d’autres plus). Son site contient au final plus de 5 700 pages HTML internes. Si on ne prend que ce type de contenu (sans les images, les CSS, les JS, les vidéos), notre crawl a donc consommé 21 kilo de C02 avec un simple clic sur « Start ».

Conclusion

Faire du SEO, cela oblige à rédiger du contenu, créer du lien et « forcer » les moteurs de recherche à venir crawler notre site. Quoi que l’on fasse, cela aura un impact écologique. C’est d’ailleurs vrai pour tous les autres métiers du Web, ou plus généralement de tous les métiers de l’informatique.

Mais nous pouvons réduire notre impact négatif (sans pour autant le supprimer). Il suffit de se concentrer sur certaines bonnes pratiques qui auront un effet bénéfique sur le référencement, l’écologie, les conversions et l’expérience utilisateur. Pensez donc systématiquement à ces aspects :

- Le temps de chargement ;

- La pertinence des contenus ;

- Ce que peut faire votre CMS dans votre dos ;

- La qualité de votre code ;

- Les actions que vous faites sans réfléchir (certaines recherches, certains crawls, certains suivis de positionnement).

Et la planète vous remerciera 🙂

Daniel Roch, consultant WordPress, Référencement et Webmarketing chez SeoMix (http://www.seomix.fr)

![Copyright Trolling en France : comprendre et contrôler les abus d’une pratique controversée [Partie 2] - Stéphanie Barge](https://www.reacteur.com/content/uploads/2024/05/2024-05-reacteur-stephanie-barge.png)

![Copyright Trolling en France : comprendre et contrôler les abus d’une pratique controversée [Partie 1]- Stéphanie Barge](https://www.reacteur.com/content/uploads/2024/04/2024-04-reacteur-stephanie-barge.png)

5